Seminar khoa học hàng tháng đã trở thành truyền thống của Trường Công nghệ Thông tin và Truyền thông (CNTT&TT) trong suốt gần 2 năm qua. Mở đầu cho năm 2025, buổi seminar khoa học tháng 1 năm 2025 của Trường, được tổ chức vào ngày 6/1/2025, hân hạnh được đón tiếp GS. Chenliang Xu đến từ Đại học Rochester (Hoa Kỳ).

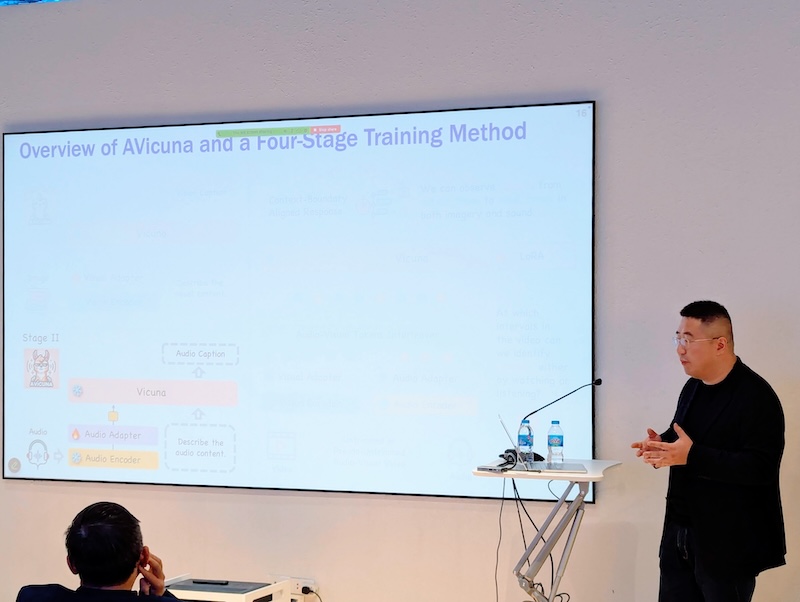

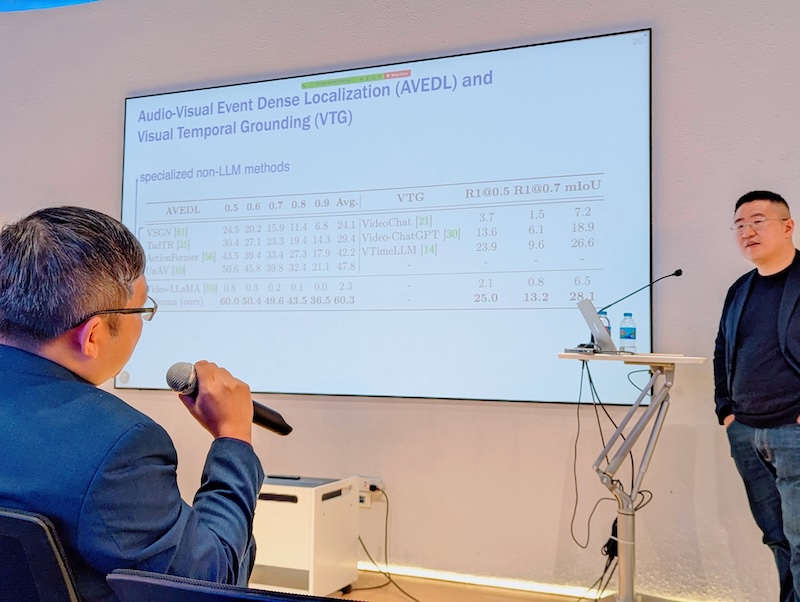

Buổi seminar tháng 1/2025 thảo luận về chủ đề “Hiểu và khôi phục khung cảnh góc nhìn thứ nhất đa phương thức” (Understand and Reconstruct Multimodal Egocentric Scenes), với trọng tâm là ứng dụng các mô hình ngôn ngữ lớn (LLMs) vào phân tích video và phát triển các hệ thống hỗ trợ. Bài trình bày đã giới thiệu các phương pháp mới sử dụng LLMs để hiểu video từ cả góc nhìn thứ ba và thứ nhất, cho thấy khả năng khái quát hóa tốt hơn so với các mô hình thị giác máy tính chuyên biệt. Các mô hình này có thể được dùng để xây dựng các tác nhân nhúng có khả năng quan sát và lắng nghe, hỗ trợ con người trong nhiều công việc và phát hiện lỗi. GS. Chenliang Xu cũng đã giới thiệu về hệ thống có khả năng lập luận và đưa ra hướng dẫn cho các tác vụ phức tạp sử dụng cả thông tin đầu vào âm thanh và hình ảnh để cải thiện khả năng dự đoán hoạt động và hướng dẫn công việc. GS. đã thảo luận về việc xây dựng bộ dữ liệu có thể huấn luyện để hiểu video và phát triển phương pháp đào tạo 4 giai đoạn cho mô hình, được huấn luyện trên 1.1 triệu cặp dữ liệu đa phương thức và văn bản, vượt trội so với các mô hình khác trong việc định vị sự kiện âm thanh-hình ảnh và các tác vụ định vị thời gian trực quan.

Ngoài ra, GS. Chenliang Xu còn giới thiệu một hệ thống có khả năng xác định và theo dõi các hành động cụ thể trong video, cũng như xuất dữ liệu có cấu trúc. Sự cần thiết phải cân bằng giữa các phương thức khác nhau trong các hệ thống đa phương thức cũng được nhấn mạnh, và hệ thống đã chứng minh khả năng xác định vị trí của các nhạc cụ trong không gian công cộng. Dữ liệu video góc nhìn thứ nhất, bao gồm bộ dữ liệu PTG chứa các công thức được thực hiện trong nhiều môi trường, và bộ dữ liệu Ego400K được tạo ra bằng cách thống nhất các chú thích từ các bộ dữ liệu khác, cũng đã được đề cập. GS. cũng đã đề cập đến các nghiên cứu về âm thanh binaural, tập trung vào việc tái tạo trường âm thanh trong môi trường mô phỏng, cùng với hệ thống tái tạo cảnh âm thanh và hình ảnh trong môi trường thực, sử dụng dữ liệu thu thập bằng loa Bluetooth 360 độ và binaural audio.

Cuối cùng, buổi seminar đã khám phá tiềm năng của các mô hình đa phương thức và LLMs trong việc hiểu video không gian thời gian, đồng thời thảo luận về những thách thức trong việc phát hiện các hoạt động trong video, nhu cầu về nhiều dữ liệu hơn và khả năng sử dụng các mô hình tổng quát. Các bước tiếp theo được đề xuất bao gồm áp dụng các kỹ thuật LLM đa phương thức vào các tình huống phức tạp hơn, nghiên cứu các phương pháp kết hợp xử lý video và âm thanh theo thời gian thực, khám phá các kỹ thuật nén dữ liệu, nghiên cứu các phương pháp xử lý video dài hơn, căn chỉnh đồng thời nhiều phương thức và điền dữ liệu bị thiếu. GS. Chenliang Xu cũng đề cập đến các thách thức như nhu cầu về tài nguyên tính toán lớn hơn và các phương pháp để lấp đầy dữ liệu bị thiếu khi tái tạo môi trường từ video, trong đó việc sử dụng các mô hình tổng quát và dữ liệu đa dạng được cho là hướng đi tiềm năng.